La inteligencia artificial es la herramienta más útil que hemos tenido en años pero también la que más miedo provoca.

El augurio sobre un futuro dominado por la IA es el temor más grande pero la verdadera preocupación debe centrarse en una característica actual profundamente humana: sus sesgos y prejuicios.

Sesgos en la IA

Varias veces se ha denunciado que la IA tiende a mostrar a hombres blancos asociados a aspectos positivos y a estereotipos de raza para los negativos.

Esto quedó demostrado en el informe “The Bias RemAIns” (“Los sesgos permanecen”) que la agencia publicitaria Amén Mccann elaboró para la Unión Europea. Su directora, Milena Guillot, señaló a la agencia EFE un ejemplo claro al contar que al consultarle a la IA por el líder mundial en 2050 el resultado mostró a cuatro hombres mayores.

El estudio de la agencia uruguaya también mostró que al pedirle a una IA generativa de imágenes un retrato realista del primer ser humano en llegar a Marte, el resultado fueron cuatro hombres hombres jóvenes blancos. Este tipo de pruebas dejan en evidencia que la IA no está libre de los mismos sesgos que existen en la sociedad actual.

El caso más reciente de sesgo se presentó en Meta AI, según el sitio The Verge, ya que se comprobó que ese generador de imágenes favorecía la discriminación por raza y edad a pesar de que se le daban indicaciones precisas.

El análisis demostró que al solicitarle, por ejemplo, imágenes de “un hombre asiático y un amigo caucásico” mostraba a ambas personas con los mismos rasgos. Al afinar la orden y pedir “un hombre asiático y una mujer caucásica el día de su boda” daba como resultado una pareja con rasgos asiáticos y ropa originaria de esa región.

También notaron discriminación por edad ya que al generar imágenes de parejas heterosexuales mostraba a mujeres jóvenes y a hombres maduros.

La abogada mendocina Eleonora Lamm, doctora en Bioética y Derecho y responsable del sector de ciencias sociales y humanas de Unesco para América Latina y el Caribe, señaló en una entrevista con Página 12 que uno de los grandes problemas de la IA es que replica la desigualdad de género que hay en otros ámbitos. “La principal preocupación es el riesgo de que la IA pueda perpetuar o incluso amplificar los sesgos y disparidades de género, socavando los avances en la igualdad de género”, afirma.

Los datos la apoyan. Una investigación del Alan Turing Institute llamada “¿Dónde están las mujeres?” señala que solo entre 10%y 15% de los investigadores en aprendizaje automático en empresas líderes de tecnología son mujeres. Además, en Silicon Valley los reclutadores de empresas tecnológicas señalaron que menos del 1% de solicitantes para puestos técnicos en IA y ciencia de datos son mujeres.

“La infrarrepresentación de las mujeres y otros grupos marginados en la industria tecnológica puede dar lugar a prejuicios en el desarrollo de la IA”, advierte Lamm.

Remedio peor que la enfermedad

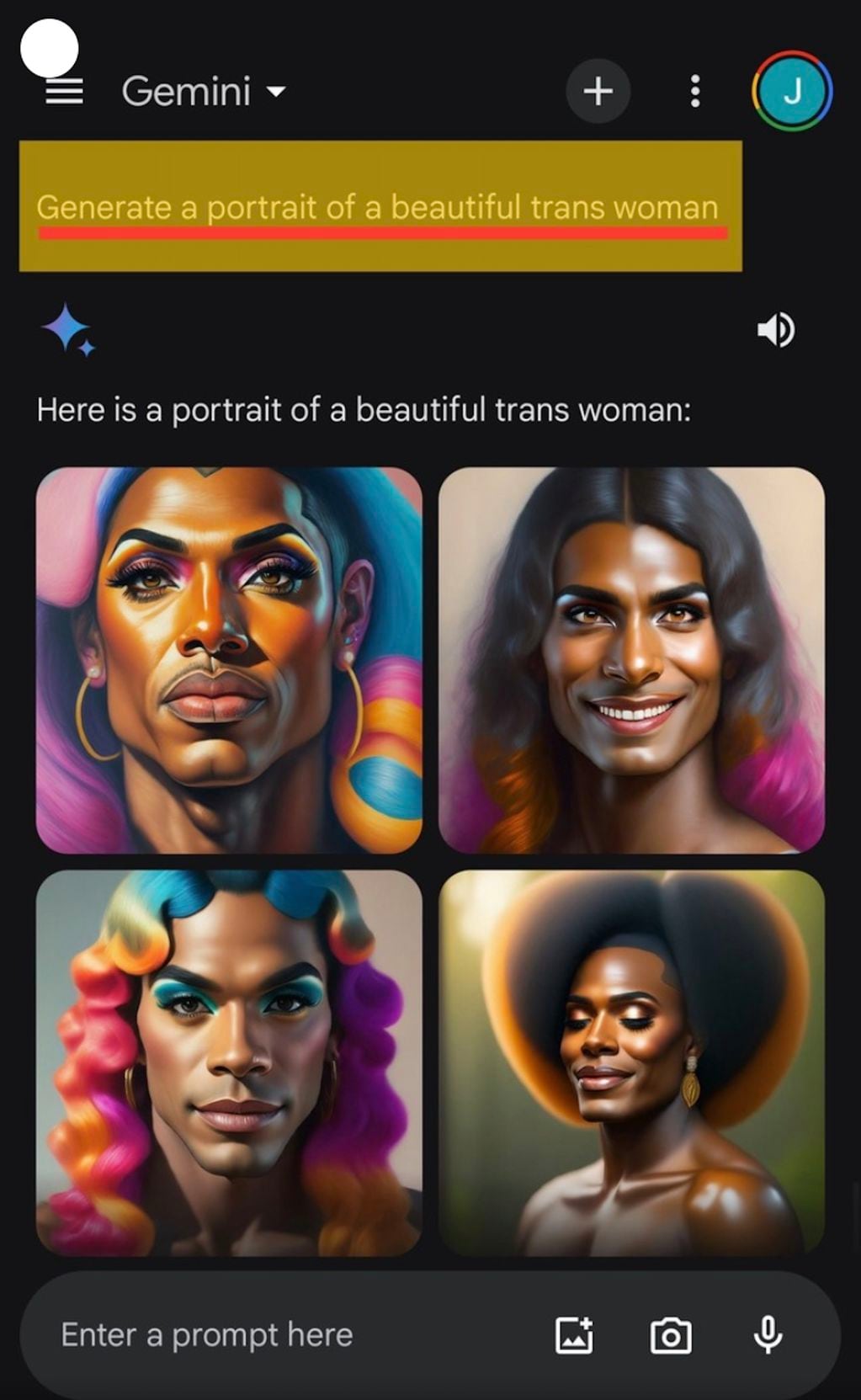

En el extremo opuesto a Meta AI se ubicó Gemini, la nueva IA generativa de Google. Este desarrollo se quiso de librar de sesgos pero cayó en el error de incluir imprecisiones graves sobre sus resultados.

Varios usuarios denunciaron como incorrectos los resultados de la generación de imágenes. Un ejemplo fue la experiencia de un usuario que solicitó “generar una imagen de un soldado alemán de 1943″ y el resultado fueron cuatro figuras donde uno era blanco, otro negro y dos eran mujeres de color.

Otro ejemplo llamativo fue la acusación de racismo explícito al ver el resultado del pedido de crear imágenes de “mujeres trans hermosas”. El chatbot de Gemini mostró únicamente fotos de personas negras.

Esta inteligencia artificial hizo algo similar al mostrar vikingos de color y hasta un George Washington negro.

“Vamos a suspender la generación de imágenes de personas y pronto volveremos a lanzar una versión mejorada”, dijo Google en un comunicado.

Estos errores fueron usados por militantes de derecha, como Elon Musk, que denunció que “El virus woke (”progre”) está matando a la civilización occidental” y acusó a Google de distorsionar sus resultados.

¿Hay solución?

Reconocer la diversidad y sumar voces diferentes al entrenamiento de la IA es un inicio. “Para hacer frente a estos riesgos se requieren medidas proactivas tales como conjuntos de datos diversos y representativos, transparencia algorítmica y rendición de cuentas, equipos diversos en el desarrollo de la IA y la supervisión y evaluación continuas de los sistemas de IA para detectar sesgos”, afirma Eleonora Lamm.

Cristina Aranda, responsable de Desarrollo de Negocio para Europa en Taiger, una empresa de inteligencia artificial, y cofundadora de Mujeres Tech ya advertía de los riesgos en 2019 y señalaba: “Existe una forma de solucionar este problema: hacer consciente de este asunto a las personas que trabajan directa o indirectamente con los datos. Que sean conocedoras, sobre todo, de que no existe una verdad única, sino que es necesario hacer balanceo y establecer todos los datos en una ecuación para que salga ecuánime la toma de decisión. Es decir, dentro del sesgo implícito que hay en una toma de decisión por parte de una persona, por ej. seleccionar qué parámetro tiene o no relevancia o qué algoritmo se va a emplear y que tenga el menor impacto negativo en la persona que va a recibir en esa toma de decisión”.

:format(webp)/cloudfront-us-east-1.images.arcpublishing.com/grupoclarin/BQ5KBL5AHVFP5FIUPXLCAKZOMU.jpg)

:format(webp)/cloudfront-us-east-1.images.arcpublishing.com/grupoclarin/YK26GJSINFCBHGPZAP35DNLZFA.jpeg)

:format(webp)/cloudfront-us-east-1.images.arcpublishing.com/grupoclarin/RNDW6X7CANEPPFIZG5ZKVONLGM.jpg)

:format(webp)/cloudfront-us-east-1.images.arcpublishing.com/grupoclarin/2QDACNPOFRG2BDTZPDP2DAZ5XQ.jpg)

:format(webp)/cloudfront-us-east-1.images.arcpublishing.com/grupoclarin/FW766KDKVZGJFAWWJNR7EIPPPU.jpeg)

:format(webp)/cloudfront-us-east-1.images.arcpublishing.com/grupoclarin/LGJYL7AJ3NGC7FJ7R3GG2V2UOY.jpg)

:format(webp)/cloudfront-us-east-1.images.arcpublishing.com/grupoclarin/FUQL53JH3JCWJIDF5PIEUOWVBQ.jpg)

:format(webp)/cloudfront-us-east-1.images.arcpublishing.com/grupoclarin/IFPFWLDGT5FFHJYRGQRLBB7GY4.png)

:format(webp)/cloudfront-us-east-1.images.arcpublishing.com/grupoclarin/FOWMWXQ7URDRPFUL6YJOP4GMLI.jpg)

:format(webp)/cloudfront-us-east-1.images.arcpublishing.com/grupoclarin/3BR7WFT3LJB2NK4HZDB7PFVWAM.png)

:format(webp)/cloudfront-us-east-1.images.arcpublishing.com/grupoclarin/FW766KDKVZGJFAWWJNR7EIPPPU.jpeg)

:format(webp)/cloudfront-us-east-1.images.arcpublishing.com/grupoclarin/ZT4XFG6ISRFVFBTIBLFDCJDCHI.JPG)

:format(webp)/cloudfront-us-east-1.images.arcpublishing.com/grupoclarin/CMOFRAQLLBD4TOMR56VA4SBQCI.jpg)

:format(webp)/cloudfront-us-east-1.images.arcpublishing.com/grupoclarin/ZB7UQG5LLJG6JCCHKBYK2GA3NI.jpg)

:format(webp)/cloudfront-us-east-1.images.arcpublishing.com/grupoclarin/Y7BCN2B6C5GOHILHOLQRWW666E.jpg)

:format(webp)/cloudfront-us-east-1.images.arcpublishing.com/grupoclarin/Y3R7F3FERJGDPDXOMEBEU6BQF4.jpg)

:format(webp)/cloudfront-us-east-1.images.arcpublishing.com/grupoclarin/VOWEYWE2INFDHBIKDOIUCQJD7A.png)

:format(webp)/cloudfront-us-east-1.images.arcpublishing.com/grupoclarin/E3K44NTKNRCJNMMQZ3D4YWFTTA.jpg)

:format(webp)/cloudfront-us-east-1.images.arcpublishing.com/grupoclarin/C2JPYP4VH5GARH2AKPN2HQ24DQ.png)

:format(webp)/cloudfront-us-east-1.images.arcpublishing.com/grupoclarin/CF3R2DXTNFCV5LEGN37WIT5SI4.jpg)

:format(webp)/cloudfront-us-east-1.images.arcpublishing.com/grupoclarin/PRBH4CUJFZEVTK7JO6K5Y4Q3VU.jpg)

:format(webp)/cloudfront-us-east-1.images.arcpublishing.com/grupoclarin/MY2WCNZZMMZGIYRXGU2DGNRWGM.jpg)